Technisches SEO sorgt dafür, dass Suchmaschinen deine Inhalte überhaupt finden, richtig interpretieren und ohne Hindernisse indexieren können. Es ist die unsichtbare, aber unverzichtbare Basis jeder erfolgreichen SEO-Strategie. Denn selbst der beste Content bringt nichts, wenn er nicht effizient gecrawlt oder durch technische Fehler blockiert wird.

Als SEO-Experte analysiere und optimiere ich technische Aspekte deiner Website systematisch – von der Ladezeit über die Informationsarchitektur bis zur Fehlerbehandlung. Ziel ist es, eine schnelle, saubere und vollständig indexierbare Website zu schaffen, die sowohl Nutzer als auch Google überzeugt.

Inhaltsverzeichnis

Was ist technisches SEO?

Technisches SEO bezeichnet alle Maßnahmen, die dafür sorgen, dass eine Website aus technischer Sicht suchmaschinenfreundlich ist. Es geht dabei nicht um Inhalte oder Backlinks, sondern um die technische Infrastruktur: Wie schnell lädt die Seite? Wird sie richtig gecrawlt? Gibt es Duplicate Content oder fehlerhafte Weiterleitungen? Sind die Core Web Vitals erfüllt?

Typische Bestandteile des technischen SEO sind:

- Ladegeschwindigkeit und Core Web Vitals

- Crawling und Indexierung

- XML-Sitemap und robots.txt

- HTTPS und Sicherheitsstandards

- Mobile Optimierung

- Website-Architektur

- Weiterleitungen und Statuscodes

- Duplicate Content vermeiden

- strukturierte Daten und Canonical Tags

Warum ist technisches SEO so wichtig?

Google will Nutzern die besten Ergebnisse liefern – und dazu gehört nicht nur inhaltliche Relevanz, sondern auch technische Qualität. Eine Website, die langsam lädt, nicht mobil optimiert ist oder technische Barrieren aufweist, wird schlechter bewertet oder gar nicht indexiert.

Technisches SEO sorgt dafür, dass:

- Google alle relevanten Seiten effizient crawlen kann

- Inhalte korrekt indexiert und dargestellt werden

- die Ladezeiten kurz und stabil bleiben

- Duplicate Content verhindert wird

- Nutzer eine reibungslose Erfahrung auf allen Geräten haben

Eine solide technische Basis ist der erste Schritt, um Inhalte und Backlinks wirklich wirken zu lassen.

Die zentralen Bereiche des technischen SEO

1. Crawling und Indexierung

Google verwendet sogenannte Crawler, um Websites zu durchsuchen. Damit sie deine Seiten finden und verstehen können, müssen Crawling- und Indexierungsprozesse reibungslos ablaufen. Ich prüfe:

- ob relevante Seiten in der robots.txt gesperrt sind

- wie viele Seiten in der Google Search Console indexiert wurden

- ob alle Canonical-Tags korrekt gesetzt sind

- ob es ungewollte Noindex-Anweisungen gibt

- wie die XML-Sitemap aufgebaut ist

Tool-Empfehlung: Screaming Frog SEO Spider oder Semrush – zum Crawling deiner gesamten Website, inkl. Analyse von Statuscodes, Indexierbarkeit und Canonicals

2. Ladezeit und Core Web Vitals

Seit 2021 gehören die Core Web Vitals zu den offiziellen Rankingfaktoren. Sie messen, wie schnell deine Seite lädt, wie stabil sie sich verhält und wie schnell Nutzer mit ihr interagieren können. Ich analysiere:

- Largest Contentful Paint (LCP)

- First Input Delay (FID)

- Cumulative Layout Shift (CLS)

- Time to First Byte (TTFB)

- Ressourcen wie JavaScript und CSS

Tool-Empfehlung: PageSpeed Insights + Lighthouse Reports von Google

3. Mobile Optimierung

Google crawlt Websites „mobile first“ – d. h. zuerst in der mobilen Version. Wenn die mobile Darstellung Fehler aufweist, leidet das gesamte Ranking. Ich überprüfe:

- Responsive Design und Media Queries

- Lesbarkeit und Klickabstände

- Darstellung in verschiedenen Bildschirmgrößen

- mobile Ladezeiten

- versteckte Inhalte in mobilen Menüs

Tool-Tipp: Mobile-Friendly-Test von Google

Visual-Idee: Vorher-Nachher-Vergleich von Desktop- vs. Mobile-Ansicht

4. HTTPS und Sicherheit

HTTPS ist Pflicht. Websites ohne SSL-Zertifikat wirken nicht nur unseriös, sondern werden von modernen Browsern als unsicher markiert. Ich prüfe:

- ob alle Seiten HTTPS nutzen

- ob http-URLs korrekt auf https weiterleiten

- ob Mixed Content (http-Ressourcen auf https-Seiten) vermieden wird

- ob Sicherheitsheader gesetzt sind (HSTS, X-Frame-Options, etc.)

5. Website-Architektur und Struktur

Eine flache, logische Seitenstruktur hilft sowohl Nutzern als auch Suchmaschinen. Ich achte auf:

- eine klare Navigation mit maximal drei Klicks zur Zielseite

- eine thematische Gliederung (Cluster)

- konsistente Breadcrumbs

- interne Verlinkung mit semantisch passenden Ankertexten

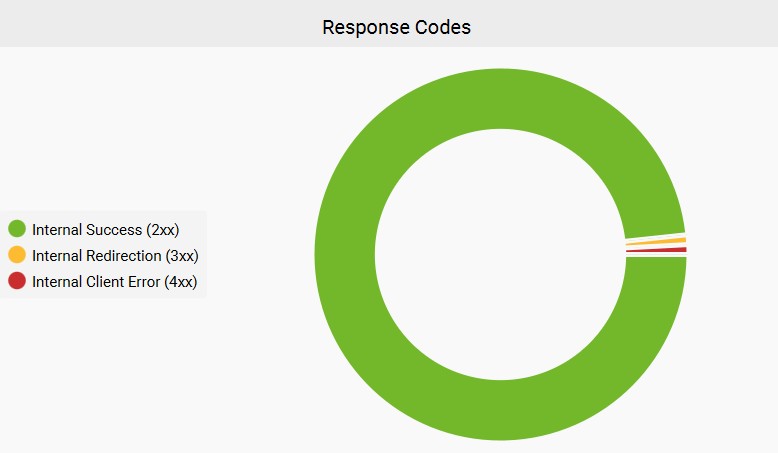

6. Statuscodes und Weiterleitungen

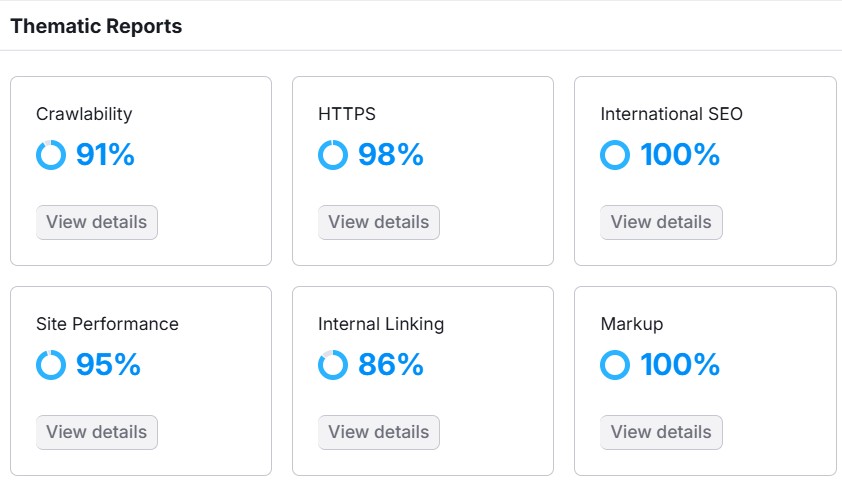

Falsche oder veraltete Weiterleitungen können das Crawling erheblich behindern. Ich analysiere mit Tools wie Screaming Frog oder Semrush:

- alle 301-, 302-, 404- und 500-Fehler

- Weiterleitungsketten (Redirect Loops)

- nicht erreichbare Seiten

- ungewollte Canonicals oder verwaiste Seiten

Ein sauberer Statuscode-Report ist entscheidend für die Crawl-Effizienz.

7. Duplicate Content und Canonicals

Gleiche Inhalte unter verschiedenen URLs führen zu Duplicate Content – was Google irritieren und das Ranking schwächen kann. Ich identifiziere:

- doppelte Produktbeschreibungen oder Kategorieseiten

- Druckversionen und Tracking-Parameter

- www vs. non-www oder trailing slashes

- falsche oder fehlende Canonical-Tags

Tool-Empfehlung: Siteliner (für kleinere Seiten) oder Semrush Site Audit

8. strukturierte Daten

Mit strukturierten Daten (Schema.org) kannst du Inhalte für Google besser kennzeichnen – z. B. Produkte, Artikel, FAQs oder Events. Das erhöht die Chance auf Rich Snippets, die deine CTR verbessern.

Ich prüfe:

- welche Daten sich sinnvoll auszeichnen lassen

- ob die Daten korrekt validiert werden

- wie sich strukturierte Daten auf Snippets auswirken

Tool-Empfehlung: Google Rich Results Test + Schema Markup Validator

9. XML-Sitemap und robots.txt

Diese beiden Dateien steuern, wie Google deine Website crawlt. Ich optimiere:

- die Struktur und Priorisierung der Sitemap

- das korrekte Einbinden in der robots.txt und Google Search Console

- Ausschluss irrelevanter Seiten (z. B. /login oder /cart)

- saubere Indexierung von paginierten Inhalten

Tipp: In der Google Search Console kannst du die Verarbeitung der Sitemap durch Google direkt überprüfen.

Technisches SEO in der Praxis: mein Prozess

- Technisches SEO-Audit mit Screaming Frog, Semrush und GSC

- Dokumentation aller Fehler und Potenziale

- Priorisierung nach Einfluss und Aufwand

- Konkrete Maßnahmenempfehlung (für Entwickler oder CMS-Nutzer)

- Umsetzung durch mich oder in Zusammenarbeit mit deinem Team

- Nachkontrolle und Reporting

Fazit: Technisches SEO ist unsichtbar – aber entscheidend

Viele technische SEO-Probleme bleiben unentdeckt, weil sie keine direkten Fehler verursachen. Aber genau sie sind es, die Rankings kosten, Crawl-Budget verschwenden oder Seiten für Google unsichtbar machen. Ich analysiere deine Website präzise, finde technische Schwachstellen und behebe sie gezielt – damit deine Inhalte das Ranking bekommen, das sie verdienen.

Hier findest du detaillierte Erklärungen zu den anderen Bereichen von SEO